Mission d'information sur la révision de la loi relative à la bioéthique

Réunion du mardi 23 octobre 2018 à 11h40

Résumé de la réunion

La réunion

Mission d'information DE LA CONFÉRENCE DES PRÉSIDENTS SUR LA RÉVISION DE LA LOI RELATIVE À LA BIOÉTHIQUE

Mardi 23 octobre 2018

Présidence de M. Xavier Breton, président de la Mission

La Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique procède à l'audition de M. David Gruson, membre du comité de direction de la Chaire Santé de Sciences Po, professeur associé à la faculté de médecine Paris-Descartes, fondateur de l'initiative « Ethik IA », et Mmes Judith Mehl et Domitille Bordet, membres d'Ethik IA.

L'audition débute à onze heures quarante.

Mes chers collègues, nous avons le plaisir d'accueillir ce matin M. David Gruson, membre du comité de direction de la chaire Santé de Sciences Po, professeur associé à la faculté de médecine Paris-Descartes, fondateur de l'initiative « Ethik IA ».

Monsieur, je vous remercie d'avoir accepté notre invitation. Vous êtes accompagné de Mmes Judith Mehl et Domitille Bordet, membres d'« Ethik IA ».

L'initiative citoyenne et académique « Ethik IA » a notamment pour but de proposer une série d'outils et de notes de cadrage pour garantir un regard humain sur les algorithmes en santé. Elle souhaite proposer, dans ce domaine, une troisième voie, entre surprotection et déréglementation. L'intelligence artificielle (IA) est l'un des enjeux majeurs de la future loi de bioéthique, votre expertise va nous être utile afin de faire mûrir nos réflexions ainsi que nos connaissances.

Je vous laisse maintenant la parole pour un exposé liminaire, nous poursuivrons ensuite par un échange de questions et de réponses.

Monsieur le président, monsieur le rapporteur, je vous remercie de l'honneur qui nous est fait de pouvoir nous exprimer devant vous, dans le cadre de la révision de la loi bioéthique.

Je vous remercie d'avoir mentionné « Ethik IA », initiative académique et citoyenne, engagée dans le débat bioéthique depuis un petit peu plus d'un an, et issue du regroupement informel d'acteurs de l'algorithmique appliquée à la santé et de professionnels de santé s'intéressant aux questions numériques.

Je voudrais plus particulièrement adresser un message à M. Touraine, avec qui nous avons eu l'occasion, à de nombreuses reprises, de dialoguer sur ces questions majeures, et que je remercie d'avoir mis l'accent sur le lien entre IA, robotisation et santé.

Je précise, par ailleurs, que j'ai eu l'honneur de codiriger avec M. Claude Kirchner, membre du Comité consultatif national d'éthique (CCNE), le groupe que celui-ci a diligenté sur l'intelligence artificielle et la robotisation. Ses conclusions ont alimenté, en bonne part, la partie « numérique et intelligence artificielle » de l'avis numéro 129 rendu par le CCNE le 25 septembre dernier. Le rapport in extenso sera prochainement diffusé ; le Comité aura naturellement à coeur de vous le transmettre.

Je m'exprimerai au nom d'« Ethik IA », mais aussi à titre personnel et académique, et j'essaierai, dans mes différents propos, de restituer les points de cohérence de la démarche, car cette audition est une étape complémentaire, un mouvement de bascule qui me semble plutôt positif sur ces questions de régulation éthique du numérique et de l'intelligence artificielle en santé.

Vous avez utilisé, monsieur le président, une expression que je n'ai pas utilisée jusqu'à présent, mais qui me va très bien, celle d'une troisième voie. En effet, je pense que c'est ce qui est en train d'émerger. Beaucoup de chemin a été parcouru depuis un an et le passage devant le Parlement de la révision de la loi bioéthique sera peut-être l'occasion de trouver le bon réglage, cette troisième voie qui permettrait à la fois de s'ouvrir à l'innovation en santé et de maîtriser les risques éthiques associés au déploiement de l'IA.

Je commencerai par donner un point de contexte, avant de vous parler de l'éthique. Ce qui me frappe, c'est la temporalité dans laquelle se déroulent les choses. Entre le moment où « Ethik IA » s'est engagée et a participé, il y a plus d'un an, à la consultation citoyenne dans le cadre de la mission confiée à M. Cédric Villani, et maintenant, nous assistons à une accélération frappante de la réflexion sur l'intelligence artificielle en santé.

Je ne vous ferai pas un cours sur l'IA ou la robotisation, je dirai juste un mot pour vous expliquer que ce que nous entendons par intelligence artificielle : le recours à un dispositif algorithmique d'aide à la décision dans le champ de la santé et de la robotisation. Si nous voulons être plus précis, il convient plutôt de parler de dispositif mécatronique : un mécanisme électronique qui a un impact sur une réalité physique sensible. Il peut donc y avoir une articulation entre l'algorithme et le robot, l'intelligence étant son bras armé opérationnel, le bras armé de la robotisation.

Le temps s'écoule vite, mais nous ne sommes pas dans un moment de révolution de la science informatique en tant que telle. Le concept d'IA et celui de machine learning, c'est-à-dire d'intelligence artificielle apprenante, ont été forgés il y a longtemps. Dans les années 1950 pour le premier, par Alan Turing et Marvin Minsky, et il y a une trentaine d'années pour le second, par des acteurs des sciences informatiques comme John Hanlon et David Goldberg, qui ont posé les principes de l'intelligence artificielle apprenante. Il s'agit d'un algorithme qui a la capacité, au fil du de traitement des données, d'écarter ce qu'on appelle en algorithmique des « hypothèses aberrantes », c'est-à-dire des données qui ont un écart-type trop grand par rapport à la valeur centrale permettant d'atteindre les objectifs de la programmation de l'algorithme.

Ces concepts ont donc été forgés il y a déjà longtemps, et aujourd'hui, avec cette accélération, nous vivons une révolution des usages de ces techniques. Quasiment chaque jour, nous assistons à l'irruption de nouvelles solutions d'IA en général, et d'IA dans le secteur de la santé en particulier, avec une concentration de ces cas d'usage sur la technique d'apprentissage par reconnaissance d'image : un cliché par imagerie par résonance magnétique (IRM) ou un scanner, sur lequel un algorithme va apprendre à reconnaître la présence d'une pathologie. Les cas d'application se trouvent donc essentiellement dans le champ de la radiologie, de la dermatologie, de l'ophtalmologie et dans certains domaines de la cancérologie.

Par ailleurs, dans des disciplines que connaît bien le professeur Touraine, il existe des versions technologiquement plus ambitieuses de l'IA, qui se déploient dans le champ de l'immunothérapie et dans celui du pilotage par les données de santé publique, avec des projets menés sur le terrain de la recherche, et avec une ligne de recherche-développement qui touche à la question de l'application de l'intelligence artificielle aux données génétiques.

Nous avons accompagné avec « Ethik IA » un projet de machine learning sur la recherche des causes génétiques des ciliopathies rénales, avec une interrogation profonde des bases de données de l'Institut des maladies génétiques Imagine, portant sur 500 000 petits patients et 5 millions de comptes rendus médicaux faisant l'objet d'un projet de recherche hospitalo-universitaire en santé (RHU).

Dans le champ de la reconnaissance d'images, vous connaissez peut-être Thérapixel, qui propose un dispositif avancé de reconnaissance d'images en mammographie. La France n'est pas absente de cette innovation, mais force est de constater que l'innovation se déploie encore plus vite ailleurs, sur des applications telles que, par exemple, le diagnostic des rétinopathies diabétiques. La Food and Drug Administration (FDA) américaine a délivré en avril dernier sa première autorisation à un algorithme de reconnaissance d'images pour la rétinopathie diabétique, pathologie qui concerne 50 % des patients atteints de diabète de type 2.

L'innovation se développant de plus en plus vite, la question se pose de la manière dont on peut la réguler, en essayant de trouver la bonne ligne d'approche des enjeux éthiques.

Ces enjeux éthiques, si vous me permettez d'utiliser une image, peuvent être présentés sous la forme d'une pyramide à trois crans, correspondant à des enjeux d'importance décroissante ou de sensibilité décroissante.

Le premier cran, que nous avons voulu mettre en évidence et que le CCNE a relayé dans son avis, est celui du manque d'innovation, qui est le risque éthique principal du numérique et de l'intelligence artificielle en santé. Cela traduit un réel changement d'approche dans la façon d'aborder ces questions. S'agissant de la télémédecine, il a fallu dix ans entre la fixation du régime juridique et l'ouverture du modèle économique par le projet de loi de financement de la sécurité sociale (PLFSS) pour 2018.

Concernant l'IA et la robotisation en santé, il faut prendre la mesure des situations dans lesquelles le blocage de notre système quant au recours au numérique et au pilotage par les algorithmes produit des conséquences non éthiques. Nous avons suivi de près, avec Jean-Louis Touraine, le dossier de l'insuffisance rénale chronique. Vous en connaissez les tenants et les aboutissants : nous continuons à vivre avec un modèle économique de l'insuffisance rénale chronique qui survalorise les séances de dialyse en centre lourd au détriment de la dialyse à domicile et de la greffe, alors même que ces solutions sont souvent plus indiquées pour les patients, médicalement comme au plan de la qualité de vie. Les dialyses en centre lourd impliquent trois séances par semaine, avec des répercussions très directes sur la vie familiale et professionnelle.

C'est un sujet sur lequel nous avons été amenés à lancer l'alerte, avec l'association des patients insuffisants rénaux chroniques Renaloo. Cependant, une prise de conscience s'opère : il s'agit d'ailleurs de la mesure 1 du plan « Ma santé 2022 », avec un ancrage dans le PLFSS. Il faut se garder de généraliser, mais les exemples de dérives que nous rencontrons montrent à quel point l'absence de pilotage par les données de santé publique génère, en réalité, une situation non éthique. Comprenez, s'agissant des exemples que j'évoquais à l'instant, qu'il ne s'agit pas de formes très élaborées d'intelligence artificielle mais simplement de dispositifs permettant de mettre en perspective des données de santé publique pertinentes. Cela consiste, par exemple, à confronter à l'échelle d'un territoire la prévalence de l'insuffisance rénale chronique et le taux d'accès à la dialyse à domicile ou à la greffe, pour essayer de faire émerger des situations de blocage ou de non-pertinence des soins.

Il s'agit d'un thème fortement développé par la ministre des solidarités et de la santé. La diffusion du pilotage par les données de santé et par les méthodologies algorithmiques en santé publique est un vecteur puissant, susceptible de venir en appui d'une politique déterminée de résorption des cas de non-pertinence des soins.

Quand ces enjeux éthiques sont abordés, il faut les associer au numérique et à l'IA en santé et garder en ligne de fond la question suivante : quel serait, si vous me permettez l'expression, le « coût d'opportunité » d'une sur-réglementation ? Trop légiférer, trop réglementer revient à retarder la résorption de ces enjeux éthiques immédiats, liés à l'absence de pilotage par les données de santé, alors même que les enjeux éthiques intrinsèques à l'intelligence artificielle, dont je vous parlerai tout à l'heure, existent bel et bien, mais à l'état de simples potentialités. Il y a donc un écart entre les dysfonctionnements liés au retard dans le recours au numérique en santé, voire à son absence – que nous pouvons constater empiriquement aujourd'hui – et les risques éthiques théoriques associés à l'IA.

Il s'agit donc là du premier cran : l'absence ou l'insuffisance de recours au numérique entraîne la persistance de situations éthiquement non acceptables

Le deuxième cran est le fait qu'une sur-réglementation, une sur-législation de ces questions aurait pour effet d'inciter les professionnels et les patients à avoir recours à des innovations de médecine algorithmique conçues hors de France, hors de l'Union européenne, dans un cadre échappant à notre régulation éthique.

Prenons l'exemple de la rétinopathie diabétique, que j'évoquais tout à l'heure. Il n'est pas du tout inconcevable d'imaginer, dans un contexte où les patients sont de plus en plus informés, qu'un patient à qui son médecin traitant dirait : « je pense que vous avez une rétinopathie diabétique, je vais vous recommander à mon confrère ophtalmologue », réponde : « je souhaite, non pas voir votre confrère, mais le cliché de mon fond d'oeil afin d'envoyer un courriel à la société qui exploite cet algorithme outre-Atlantique, et qui passe pour super-fiable dans ses diagnostics ».

Concrètement, la possibilité pour un patient d'accéder à cette innovation provoque une pratique d'évitement du système de santé français. En outre, cet accès à l'information, mais aussi la conditionnalité matérielle qu'impliquerait le recours à cette solution de médecine algorithmique externe, généreraient un biais très fort en fonction des ressources et, partant, une vraie menace, si nous ne développons pas de solutions de médecine algorithmique dans le cadre français ou européen, pour le principe de solidarité qui est à la base de la sécurité sociale.

Après avoir posé les deux risques principaux, nous pouvons aborder les sujets intrinsèquement liés à l'intelligence artificielle en santé. Ce sont, certes, des questions surabondamment abordées par la science-fiction, mais la réalité n'est pas celle d'un risque de domination de l'homme par la machine : elle est faite de risques plus spécifiques, que nous avons essayé de qualifier et que le CCNE a repris dans son avis n° 129. Je le dis, là aussi, avec mes mots, pour que vous compreniez bien les choses, même si l'expression du CCNE, à laquelle je me permets de vous renvoyer, est peut-être plus précise que celle que je vais utiliser. Les risques sont de deux ordres.

Le premier groupe de risques consiste en ce que nous pourrions appeler des risques de délégation. D'une part, la délégation de la décision médicale à l'intelligence artificielle. Vous comprenez bien le sujet : si un algorithme forme une proposition thérapeutique assise sur des centaines de milliers de cas, avec un taux de certitude de 99 %, le risque est, non pas en droit mais en fait, que le médecin se transforme en presse-bouton de cette solution, sans prendre de recul. D'autre part, le risque d'une délégation de consentement du patient. Permettez-moi un parallèle trivial. Quand je regarde Netflix, l'intelligence artificielle me propose une série qui peut se prévaloir de 99 % de personnes satisfaites. Plus je regarde ses propositions, plus l'IA me connaît, et mieux elle sait par avance ce que je veux voir – avant que je le sache moi-même ! Certes, en droit, je suis toujours libre de refuser la proposition qui m'est faite, mais en pratique le consentement du consommateur risque de s'éroder. Il en va de même dans le champ de la médecine pour le consentement du patient.

Le second groupe de risques, qui tient davantage à la matière même de l'intelligence artificielle, consiste en la mise en confrontation de l'intérêt individuel et de l'intérêt collectif. Le processus d'intelligence artificielle apprenante consiste à écarter les données aberrantes au fil du traitement et du temps. Mais, en médecine, les données aberrantes correspondent à des cas individuels, de sorte que la mécanique à l'oeuvre peut aboutir à ne plus prendre en compte certaines situations individuelles, dans l'intérêt collectif, pour atteindre les objectifs du programme. Dans le cas, par exemple, de patients en fin de vie, nous pourrions être amenés à considérer qu'il est plus efficace, dans l'intérêt du plus grand nombre, de ne plus proposer une thérapeutique très coûteuse.

Il s'agit là d'une question éthique importante, complexe, qu'il ne faut sans doute pas traiter en termes moraux – « est-ce bien ou mal ? ». Étant donné les situations non éthiques que nous continuons de subir faute de pilotage suffisant par les données, l'IA contribuera à améliorer la qualité et l'efficience du système, au prix d'un risque intrinsèque de minoration de la prise en compte de certaines situations individuelles.

La zone de risque est celle d'une combinaison des risques de délégation de décision médicale, de délégation du consentement du patient et de minoration de la prise en compte de l'individu par rapport au collectif. Finalement, le risque est que nous nous retrouvions avec un outil tellement puissant, qui améliore tellement l'efficacité et la qualité du système de santé, que nous ne nous rendrions pas compte, au fil de l'eau, de la concrétisation de risques éthiques, tant la satisfaction collective qui se dégagerait de l'amélioration du système serait forte.

Pour revenir à mon exemple, quand je regarde Netflix, je dois vraiment faire un effort pour prendre du recul et avoir conscience de tout ce que je rate quand je ne fais que regarder les séries proposées par Netflix. En effet, d'autres choses existent, mais cela nécessite un effort pour prendre du recul car je juge le service efficace et de qualité ; mais il génère des effets de bord et des effets de concentration sur un seul schéma de décision.

Une fois ce constat posé, quel est le niveau d'intervention pertinent à l'occasion de la révision de la loi de bioéthique ? Il est nécessaire de mesurer que la France a une responsabilité majeure, la révision de la loi française de bioéthique arrivant en avance par rapport à une série d'autres processus de régulation. Les concertations engagées au niveau européen sur ces questions sont encore à leurs débuts. Les principes d'action législative dans d'autres pays étant quasi inexistants, la France sera donc la première à intervenir sur ces questions.

Une responsabilité forte, donc, mais si cette révision de la loi de bioéthique aboutit à quelque chose qui fonctionne, la France aura peut-être la capacité d'incarner une troisième voie susceptible de rayonner dans d'autres pays, à condition de le faire en bonne intelligence.

Alors, que faut-il faire ou ne pas faire ? Je vous appelle tout d'abord à la « modération » législative sur ces questions, pour ne pas bloquer l'innovation et au regard des enjeux de responsabilité pour les professionnels. En effet, aujourd'hui, l'essentiel des dommages susceptibles de résulter de l'intelligence artificielle peuvent être pris en compte dans les cadres juridiques existants, essentiellement par le régime juridique de la responsabilité du fait des choses. Si l'utilisation de robots ou d'algorithmes cause un dommage dans le cadre de son fonctionnement courant, c'est l'utilisateur – médecin libéral ou établissement hospitalier – qui doit être déclaré responsable, sauf dysfonctionnement du procédé robotique ou algorithmique, auquel cas s'appliquera le régime de la loi du 19 mai 1998 sur la responsabilité du fait des produits défectueux. Cette loi transpose une directive communautaire de 1985 qui stipule qu'en cas de dysfonctionnement, le responsable est le producteur.

La Cour de justice de l'Union européenne, dans une décision de décembre 2017, a assimilé un logiciel d'aide à la prescription médicale à un dispositif médical, de sorte que, par extension, un algorithme d'aide à la décision médicale intégrerait le régime des dispositifs médicaux, donc le régime de responsabilité du producteur en cas de dysfonctionnement de l'algorithme. Vous n'avez donc pas besoin de légiférer.

Toutes les questions sont-elles pour autant réglées ad vitam aeternam ? Non.

La loi du 19 mai 1998 comporte une clause d'exonération de la responsabilité du producteur, relative au risque de développement, risque qu'il n'est pas possible d'anticiper au regard des connaissances scientifiques disponibles au moment de la mise sur le marché du produit. Mais pour l'IA, ce risque n'est pas théorique, car l'algorithme, s'améliorant au fil du traitement des données, est susceptible de devenir si différent de sa version initiale que le producteur de la solution d'IA pourrait exciper de la clause exonératoire de risque de développement pour échapper à l'indemnisation du dommage.

Dans un tel cas, qui n'a pas été envisagé et qui ne correspond pas jusqu'ici à un sinistre constaté, la victime ne serait pas indemnisée. Il n'existe pas d'exemple de dommages ressortissants de machine learning pur : nous n'en sommes pas à ce stade de développement de l'IA.

La question se posera-t-elle ? Oui. Se posera-t-elle de manière importante ? Très probablement, vu l'effervescence de solutions pratiques. Faut-il pour autant aborder la question dans un cadre strictement national ? Je ne le crois pas, dans la mesure où, si nous tentions, dans la révision à venir de la loi de bioéthique, de fixer un régime d'indemnisation des dommages du fait du machine learning en France, celle-ci risquerait de faire cavalier seul, ce qui serait une source d'inconvénients importants pour le développement de l'innovation en intelligence artificielle dans notre pays.

Il conviendrait plutôt de faire passer un message et d'enclencher rapidement une initiative européenne pour imaginer la construction d'un régime de responsabilité sans faute pour les dommages issus de l'usage de solutions de machine learning pur : un régime dont on réglerait, au fil du temps, les paramètres afin de tenir compte de la sinistralité constatée, et ce avec un mécanisme d'amendements à déterminer – cotisations des assureurs, intervention de la puissance publique… La question mérite d'être posée sur un plan théorique, mais il y aurait plus d'inconvénients à déséquilibrer les régimes actuels de responsabilité des professionnels que d'avantages à régler des questions qui ne se posent pas encore.

Alors, que faire en pratique ? Je vous ferai passer un dossier. Nous avons en effet proposé, dans le cadre « Ethik IA », deux adaptations législatives, que le CCNE a bien voulu relayer dans son avis n° 129.

L'idée est de légiférer un minimum tout en répondant aux enjeux éthiques, donc d'élaborer une législation qui serait réellement efficace car venant en complément des mesures actuelles. Vous venez de transposer le règlement général sur la protection des données (RGPD), auquel doivent se conformer, y compris sur le plan pénal, les régimes protecteurs relatifs aux données personnelles, régimes applicables à la protection des données de santé. Nous ne sommes donc pas dans un environnement vierge de toute régulation législative, sans même parler des décisions que pourraient prendre les juges en cas de contentieux.

Nous proposons d'ajouter à la loi deux dispositions aujourd'hui manquantes. La première est un élargissement du devoir d'information du médecin, afin que le patient soit informé, préalablement à l'intervention, du recours à un algorithme d'aide à la décision médicale. La seconde, plus innovante, serait l'affirmation d'un principe qui nous semble fondamental : le principe de garantie humaine de l'intelligence artificielle. En d'autres termes, le recours à la médecine algorithmique serait subordonné à la supervision humaine du processus.

Dans un rapport de janvier 2018, sous l'impulsion du docteur Jacques Lucas, le Conseil national de l'Ordre des médecins (CNOM) avait appelé au développement d'un environnement de soft law, de guides de bonnes pratiques, pour accompagner le développement du numérique en santé. À partir du moment où la représentation nationale reconnaîtra le principe de garantie humaine, il conviendra de susciter, d'encourager l'émergence de techniques opérationnelles, de recommandations de bonnes pratiques, pour essayer de mettre en oeuvre concrètement cette garantie humaine de l'IA. Je prendrai l'exemple de deux méthodes que nous avons proposées.

Nous avons d'abord formulé avec la Société française de télémédecine, l'idée d'une télémédecine de garantie humaine de l'IA. Par exemple, un premier médecin confronté au patient et à qui l'algorithme propose une solution thérapeutique correspondant au cas clinique, demande un avis à un second médecin, plus spécialisé. Ce second avis favorisera une prise de recul du premier médecin. La notion de « second avis » humain existant déjà, nous serions donc dans une réflexion connexe.

Le deuxième exemple de technique de garantie humaine serait ce que nous pouvons appeler un « collège de garantie humaine », susceptible d'être mis en place à l'échelle d'un territoire ou d'un établissement. L'idée serait d'étudier, tous les deux ou trois mois, vingt ou trente dossiers médicaux pour lesquels un diagnostic algorithmique a été livré, puis de faire appel à un second avis, cette fois-ci humain. Ce collège serait composé de médecins, de soignants et de représentants des usagers, qui essaieraient de définir si l'algorithme d'aide à la décision reste efficace dans son diagnostic et si les risques éthiques dont nous parlions tout à l'heure – délégation de décision médicale, délégation du consentement du patient et risque de minoration de la prise en compte de la personne par rapport au collectif – peuvent être maîtrisés concrètement au fil du temps. Il s'agit de susciter et d'encourager la définition de bonnes pratiques, sous l'égide de la Haute Autorité de santé (HAS).

La définition des méthodes de régulation est finalement, en soi, un champ de recherche, puisqu'il faut inventer des manières nouvelles de concevoir la régulation éthique. C'est ce que nous avons essayé de faire avec les équipes d'Imagine, en proposant des normes de bon usage de l'IA appliquées aux données génomiques, en essayant de définir des principes de protection un peu plus précis sur ces données très sensibles et en mettant en exergue le fait qu'il existe aujourd'hui, dans notre droit, des freins au développement du recours à l'IA et aux avancées en génétique que celui-ci permet.

Aujourd'hui, un non-clinicien, un data manager, ne peut pas utilise des données cliniques dans le cadre d'une d'application de l'IA à la recherche sur les données génétiques. C'est un vrai blocage. Nous proposons de mettre en place un périmètre de sensibilité dans lequel ces traitements plus profonds pourraient être mis en oeuvre, sous la condition de procédés de sécurisation informatiques plus avancés.

Telles sont les propositions que nous formulons pour une régulation positive de l'intelligence artificielle.

Je terminerai sur la technique de régulation et l'état du débat public, où l'on entend notamment un discours ambiant sur la question de la transparence du code. Certains expliquent, de façon vigoureuse, que pour réguler l'IA il faut rendre le code transparent, voire le mettre sur la place publique. Je ne crois pas à cette solution, qui relève d'une confusion assez dangereuse. Si un centre de recherche ou un acteur industriel investit plusieurs millions d'euros pour écrire un code d'aide algorithmique au diagnostic et doit le mettre sur la place publique, non seulement cette idée n'est pas très rationnelle en termes d'investissement et d'innovation, mais, surtout, c'est la meilleure assurance que cette solution sera captée par un opérateur moins éthique que lui. Par ailleurs, la transparence en matière de code ne sert à rien pour un patient.

Ensuite, il y a cette confusion un peu dangereuse entre contrôle technique et contrôle qualité. Lorsque j'étais directeur général de centre hospitalier universitaire (CHU), il m'est arrivé d'acheter des équipements lourds. Quand vous achetez un équipement d'IRM, vous vous entourez d'avis médicaux et vous vérifiez que le producteur a procédé au contrôle technique préalable, s'agissant de la mise sur le marché des dispositifs de santé. Le producteur doit assurer un contrôle technique global qui intègre des éléments de vérification portant sur le code informatique lui-même. Avant la mise sur le marché, il doit donner à l'utilisateur la garantie de la récurrence de ce contrôle technique. C'est un contrôle de digilence qui peut aller très loin, tant sur le code que sur l'algorithme lui-même.

Cette condition sine qua non ne doit pas être confondue avec le contrôle qualité. Le contrôle qualité porte, en amont, sur la qualité de l'approvisionnement en données de santé – données qui doivent être pertinentes médicalement et collectées avec le consentement des patients – et, a posteriori, sur l'emploi de techniques de pilotage qualité relevant de la méthode de la garantie humaine. L'algorithme d'aide à la décision reste-t-il médicalement efficace au fil du temps ? L'utilisateur a-t-il un niveau de supervision suffisant pour s'assurer que les effets de bord éthiques sont maîtrisés au fil du temps ?

La clarté est donc un enjeu important dans ce débat, en raison des transformations majeures qui vont être associées à l'usage de l'IA en santé ainsi que d'un effet de buzz cosmétique provenant d'un intérêt marqué des médias sur ces questions – qui est positif en soi. Or il ne faut surtout pas donner à l'IA un statut particulier par rapport aux autres innovations techniques, et ne pas perdre de vue non plus la nécessité et la complémentarité du contrôle technique et du contrôle de qualité.

Tels sont, monsieur le président, monsieur le rapporteur, les constats que je voulais porter à votre attention. Je vous transmettrai, en complément, des éléments de production écrits qui pourront vous aider dans vos travaux.

Je vous remercie.

Dans son avis n° 129, le CCNE juge que le droit positif reste adapté en ce qui concerne le recueil de consentement du patient à l'utilisation de ses données de santé, mais estime cependant que ce droit positif « gagnerait à être complété d'outils pratiques nouveaux et réactualisés pour garantir l'efficacité du recueil de ce consentement ». Quels pourraient être, selon vous, ces outils pratiques nouveaux et selon quelles modalités devraient-ils être utilisés ?

Le CCNE suggère par ailleurs la création d'un comité d'éthique du numérique. Y êtes-vous favorable ?

Je répondrai d'abord à votre seconde question, qui est, finalement, une question plus institutionnelle sur laquelle mon expression personnelle n'a pas vraiment de valeur ajoutée par rapport à l'expression du CCNE. Je vous ferai donc un retour pratique, fondé sur mon expérience opérationnelle.

L'impulsion que vous avez donnée sur cette question doit être soulignée, à savoir la construction, depuis un an, d'un début d'édifice de régulation positive de l'IA en santé et de la robotisation. Nous pouvons être collectivement fiers de ce qui a été versé au débat public ces derniers mois. Votre travail y contribuera, j'en suis convaincu.

Je vous recommande de vous emparer du projet de normes de bonnes pratiques appliquées aux données génomiques, préparées avec Imagine. C'est le résultat de six mois de travail au cours desquels nous avons cherché à répondre à des questions très précises.

Si l'idée venait à la représentation nationale de mettre en place une autorité de régulation éthique des algorithmes, je crains qu'elle soit désectorisée ou excessivement transverse et qu'il faille beaucoup de temps – de temps institutionnel – pour la mise en place, le calage, la saisie de dossiers, avant qu'elle puisse commencer à intervenir sur des algorithmes précis. Même un délai de six mois seulement pour la mise en place institutionnelle de cette autorité pourrait être irrémédiablement préjudiciable à la France, dans un contexte où la technologie se développe si vite qu'il faut rendre très rapidement opérationnel ce patrimoine réel qu'est un dispositif de régulation positive de l'IA.

Pour ce qui est du pilotage de la qualité, une solution pourrait être organisée sous l'égide de la HAS, ouvrant la possibilité de laisser se développer un environnement de recommandations de bonnes pratiques animé par le privé, avec un couple « utilisateur et garant qualité » qui permette de le faire vivre activement.

S'agissant du comité d'éthique du numérique, j'interprète l'avis du CCNE comme une volonté assez pragmatique de trouver une voie de passage entre ce capital d'expertise spécialisé sur la bioéthique, en tant que telle, et la nécessité d'opérer une transition progressive vers une régulation éthique plus transversale des algorithmes. Mais si la France, seule, crée en 2018 une autorité de régulation éthique des algorithmes dans le champ de la santé, nous y perdrons beaucoup en finesse de régulation pratique.

Votre première question le montre d'ailleurs très concrètement, à travers le sujet du recueil du consentement. Il est indiqué qu'il n'y a pas lieu de modifier le droit français sur le principe du consentement du patient, puisqu'il est déjà écrit que le consentement du patient doit être recueilli préalablement à l'administration d'une thérapeutique. Ce principe est vrai et doit rester vrai à l'heure de l'intelligence artificielle ; c'est une garantie impérative.

Comment aménager ce recueil du consentement ? Il faut sans doute l'aménager dans deux directions – il s'agit là, non pas d'un travail de construction législative, mais d'une recommandation de bonnes pratiques à établir avec les professionnels et les représentants de patients. D'abord, peut-être, dans le sens d'un assouplissement. Pour comprendre comment fonctionne l'IA en santé, prenons l'image d'un faisceau d'options causales, avec un algorithme qui va imaginer, à partir d'une situation clinique donnée, un certain nombre de prises en charge possibles, dont certaines ne se réaliseront peut-être pas au fil du parcours de prise en charge, mais aussi avec un espace-temps qui va se contracter assez fortement par rapport au processus actuel de prise en charge, sous l'effet de la rapidité d'évolution de la technologie.

Il y a donc, sans doute, une voie pour capitaliser sur la valeur ajoutée de cette technologie, et ce sans remettre en cause le principe de recueil du consentement : mettre en place des dispositifs de recueil plus séquentiels. En d'autres termes, aller rechercher le consentement du patient, en amont de la prise en charge, y compris sur des options qui ne se réaliseraient pas au fil du processus, et ce afin de pouvoir gérer cette compression de l'espace-temps.

On peut également, dans une seconde direction, mettre en place des mécanismes de recueil du consentement plus protecteurs, notamment pour les personnes les plus vulnérables – personnes âgées, personnes handicapées –, pour qui la compréhension même des enjeux associés à l'expression du consentement en médecine algorithmique pourrait être très difficile.

Nous avons proposé – en essayant d'utiliser les mécanismes législatifs existants – de réhabiliter un outil, celui de « personne de confiance », et de lui donner un nouveau cas d'usage. Cet outil est précieux mais encore insuffisamment utilisé dans notre système de santé. Il conviendrait de mobiliser la personne de confiance en tant que personne qui va aider le patient à exprimer un avis éclairé par rapport à la proposition thérapeutique formulée par algorithme. Ce rôle pourrait être joué, dans certains cas, par des associations de patients, en développant des programmes de formation.

Il s'agit là d'un message clé si nous souhaitons garder une dose de libre-arbitre, à la fois dans la décision médicale et dans le consentement du patient. Il faut poser un principe de garantie humaine, et en même temps, aider les acteurs à utiliser des outils très pratiques pour prendre du recul par rapport à ces technologies.

Monsieur Gruson, un grand merci pour cet exposé complet et riche, sur un sujet délicat. Je vous poserai trois questions.

L'évolution dans ce domaine est inéluctable et nous sommes amenés, vous l'avez bien montré, à choisir une voie moyenne entre un progressisme incontrôlé, potentiellement dangereux, et une vision trop conservatrice qui nous mettrait très rapidement au ban des nations qui utilisent ces moyens nouveaux, de façon bénéfique.

En France, nous disposons d'une masse de données de santé considérable, peut-être même unique dans le monde, pour diverses raisons, et qui suscitent certains appétits. Nous observons déjà que certains réseaux commerciaux utilisent ces données sans que nous sachions précisément quelle est la source des informations qu'ils exploitent.

Ainsi, des malades reçoivent des propositions d'objets connectés, parfois utiles, mais pas toujours indispensables. Ils ont été repérés spécifiquement, que ce soit en secteur libéral ou en secteur public, sur la base de données les concernant qui circulent. Jusqu'à présent, les conséquences ne sont pas très graves, mais l'amplification de ce phénomène serait regrettable. Comment s'assurer qu'il n'y ait pas de plus en plus de fuites sur des données de santé, utilisées à des fins essentiellement commerciales ? Êtes-vous plutôt favorable à un moyen de coercition a priori, ou à un contrôle a posteriori assorti de sanctions ?

Deuxièmement, vous nous avez cité un certain nombre de difficultés à surmonter, mais j'aimerais que vous nous disiez quelles sont les faiblesses que vous percevez comme les plus préoccupantes dans notre système français ? Pouvez-vous hiérarchiser, en quelque sorte, les difficultés que nous aurons à affronter dans les toutes prochaines années, et nous suggérer une façon de les résoudre – dans le respect, bien entendu, des valeurs éthiques françaises que je n'ai pas besoin de rappeler ?

Troisièmement, vous avez évoqué la modification de la relation médecin-malade, qui, au lieu d'être fondée, comme dans le passé, essentiellement sur une confiance réciproque, devient de plus en plus une codécision. Certains se félicitent de cette évolution, d'autres la regrettent, mais elle est inéluctable. Le malade participe de plus en plus à la décision, il est moins passif et peut invoquer le recours à certaines expertises extérieures.

Le recours à la téléexpertise passe, pour l'instant, par l'intermédiaire de médecins, mais demain d'autres vecteurs pourront être trouvés. Comment imaginer que cette relation, qui se modifie dans son fondement, soit efficacement, correctement et rapidement enseignée aux étudiants en médecine d'aujourd'hui qui seront les médecins de demain et qui baigneront dans l'intelligence artificielle ?

Je répondrai de manière groupée aux deux questions : comment traiter les dérives dans l'accès aux données de santé, et quelle est la faiblesse principale de notre système ?

La France dispose de données de santé de qualité mais aujourd'hui faiblement utilisées et valorisées pour améliorer le système de santé. Le constat a été dressé par le rapport de la mission de préfiguration du Health Data Hub souhaité par le Président de la République, rendu le 12 octobre. Dans son avis, le Comité consultatif national d'éthique indique que cette plateforme est une bonne voie de passage. Si nous sommes capables de créer cette interface technologique, qui permettra d'assurer un niveau de sécurisation et d'ouvrir un partage plus large des données de santé dans un cadre qui soit créateur de confiance, c'est sans doute la voie de passage à privilégier.

Si ce message est bien reçu en France, il conviendra assez vite de le faire passer au niveau européen, pour essayer d'avoir une démarche commune sur ces questions.

Quelle est la faiblesse prioritaire à traiter ? Il faudrait imaginer un régime plus efficace d'alimentation de ce futur Health Data Hub en données de santé. En effet, à partir du moment où nous créons une infrastructure technologique sécurisée, avec la garantie de bon fonctionnement et de sécurisation qu'apporte la puissance publique, nous pouvons peut-être nous permettre d'élaborer un mécanisme de recueil facilité de données. Notre droit connaît déjà un mécanisme de consentement présumé pour les prélèvements d'organes ; ce qui existe pour les organes pourrait exister, dès lors que le cadre de confiance a été créé, pour des données de santé dont le traitement serait mobilisé à des fins d'amélioration de la qualité et de l'efficacité du système.

Cela nous permettrait de sortir de ce que nous connaissons aujourd'hui, à savoir des bases de données de très bonne qualité, mais qui ne communiquent pas entre elles : des bases de données médico-administratives, comme le Système national d'information inter-régimes de l'assurance maladie (SNIIRAM), et des données cliniques réelles, comme les clichés d'imagerie qui sont aujourd'hui stockés dans les cabinets des radiologues ou dans les établissements de santé.

Je crois à une clé d'entrée pour le Hub, à la fois par des thématiques amenées par les associations de patients, et par les spécialités. Par exemple, les radiologues se sont organisés en jetant les bases d'un écosystème français d'IA en radiologie. Ils ont établi cet écosystème, avec leur société savante, la Société française de radiologie (SFR), la Fédération nationale des médecins radiologues (FNMR) et le Syndicat des radiologues hospitaliers (SRH). Ils ont essayé de définir des bases efficaces médicalement et responsables éthiquement de l'émergence de l'IA dans la discipline. Il y a là un point de contact à imaginer dans l'opérationnalité de l'émergence de l'IA.

Enfin, vous avez évidemment raison de mettre l'accent sur un enjeu absolument central, qui est celui de l'adaptation de la formation. La France a pris du retard. Elle commence à le résorber après une prise de conscience. D'abord du fait de l'annonce, par la Conférence des doyens des facultés de médecine (CDFM), de la mise en place en 2019 d'un module de sensibilisation des étudiants aux enjeux de la médecine algorithmique dès la première année de médecine, via le groupement d'intérêt public (GIP) de l'Université du numérique en santé. Il conviendra de développer des contenus plus spécialisés. Ensuite, du fait de l'annonce par la directrice générale de l'Agence nationale du développement professionnel continu (ANDPC) de l'inscription, dès 2019, de l'intelligence artificielle comme orientation prioritaire de développement professionnel continu (DPC) afin d'enclencher une dynamique de formation continue auprès des médecins.

Je terminerai en abordant la question de l'impact de l'IA sur les métiers, même s'il ne s'agit pas forcément d'un domaine législatif, car les changements peuvent être importants. C'est un sujet que nous avons étudié avec l'Institut Montaigne ; un rapport sera publié dans les prochains jours. Le débat public est très concentré sur l'impact de l'IA sur les spécialités médicales, mais en réalité, pour ces spécialités, les effets « ressources humaines » (RH) ne sont pas acquis et nous ne pouvons pas affirmer que telle ou telle spécialité médicale disparaîtra. Cela dépendra de l'évolution technologique et des choix qui seront faits pour les professions paramédicales adjacentes – radiologue, manipulateur en électroradiologie médicale, etc.

En revanche, nous mesurons d'ores et déjà des effets importants du déploiement de l'IA sur les fonctions ou les métiers supports. Comme dans d'autres secteurs de la vie économique et sociale, les fonctions du back office du soin sont l'objet de transformations très significatives pour lesquelles il est nécessaire de mettre en place une stratégie d'accompagnement, afin d'éviter des impacts brutaux pour certains métiers.

Monsieur Gruson, je vous remercie pour votre présentation et vos interventions.

Lors d'un point de presse, vous aviez insisté sur le développement absolument irréversible de l'intelligence artificielle. Nous pouvons le comprendre, et cela crée des opportunités intéressantes, notamment dans le champ sanitaire et médico-social. Vous aviez également dit que la France disposait d'atouts, notamment au niveau des mathématiques et des algorithmes, mais que nous accusions du retard en termes de déploiement industriel. Comment pourrions-nous avancer plus vite dans ce dernier domaine ?

Vous aviez en outre proposé différentes clés pour une régulation de l'intelligence artificielle, notamment la création d'une fondation, inscrite au sein du CCNE, pour tout ce qui concerne le déploiement de la robotisation. Pouvez-vous nous en dire quelques mots ?

Enfin, je note que vous avez appelé notre attention sur le risque de sur-réglementation et d'empilement législatif.

Concernant la partie industrielle, ma première préconisation est celle d'une modération législative, d'une juste mesure, pour ne pas créer un environnement encore plus compliqué pour les acteurs de l'innovation.

Dans cette émergence de solutions innovantes, le Health Data Hub, avec un mode d'alimentation adapté, serait un vrai atout pour franchir des étapes complémentaires.

Un troisième point relève plus du choix stratégique : il s'agirait de repérer quelle est la zone de compétitivité de la France sur l'intelligence artificielle en santé. Je vais peut-être vous paraître un peu brutal, et c'est évidemment un point de vue personnel : je ne crois pas que nous puissions entrer en compétition avec des fabricants de solutions d'IA très généralistes dans le secteur de la santé. Ils ont trop de longueurs d'avance.

En effet, les solutions d'IA généralistes qui se construisent sont le prolongement de solutions informatiques numériques généralistes que vous connaissez déjà, et pour lesquelles la France et l'Union européenne accusent un retard trop important.

En revanche, nous avons sans doute la possibilité de développer une stratégie ambitieuse pour élaborer des solutions d'IA de référence dans des champs de spécialité : en radiologie, en cancérologie, en dermatologie ou en ophtalmologie.

Tout ce qui fait l'excellence de la médecine française pourrait faire émerger ces solutions, si une stratégie déterminée identifiait un nombre resserré de priorités sur lesquelles nous nous mobiliserions et si les moyens du programme d'investissement d'avenir étaient résolument orientés vers elles. Ces solutions auraient vocation à devenir des algorithmes de référence dans tel ou tel champ de spécialité et qui, demain, viendraient se « plugger » sur des solutions d'IA, éventuellement conçues ailleurs. Mais si nous agissons intelligemment, à la fois en termes de cadrage législatif et de régulation, nous pourrions essayer de les acclimater dans un environnement éthique conforme à nos valeurs.

S'agissant de la fondation, c'est une proposition que nous avions introduite au cours de la consultation qui avait eu lieu lors de la mission Villani. L'idée est de définir un vecteur permettant d'accueillir des financements publics et privés, le cas échéant industriels, dans un cadre vierge de tout conflit d'intérêts et avec une exigence déontologique très forte.

« Ethik IA » a été construit sans aucun moyen, au titre de nos missions académiques respectives et de l'engagement citoyen que nous avons porté collectivement. Avec un investissement de quelques centaines de milliers d'euros, pas plus, nous pourrions amorcer le mouvement et avancer.

Il y a trois moments dans le processus de régulation positive de l'IA. Le premier est celui de la recherche et du développement pour la construction de ces outils de régulation positive et le développement des techniques de régulation de soft law appropriées. Le lieu de validation de ces instruments devra être indépendant : pourquoi pas la HAS ? Pourquoi pas des techniques de normalisation discutées avec l'Association française de normalisation (AFNOR) ? Enfin, a posteriori, vient le besoin d'accompagnement et la conduite du changement. Comment aider les acteurs à se saisir de ces nouveaux outils de garantie humaine de l'intelligence artificielle ? Comment les faire vivre concrètement ? Comment aider les établissements de santé qui voudraient se doter d'un collège de garantie humaine pour suivre, au fil du temps, le déploiement de l'IA ? Et comment gérer, dans une vraie stratégie de conduite du changement, les impacts sur les métiers de la santé et du champ sanitaire et médico-social ?

L'audition s'achève à douze heures cinquante.

Membres présents ou excusés

Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique

Réunion du mardi 23 octobre 2018 à 11 h 40

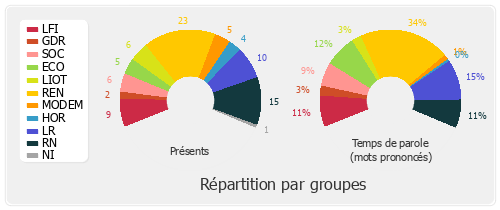

Présents. – M. Xavier Breton, M. Alain Ramadier, M. Jean-Louis Touraine

Excusés : - Mme Bérengère Poletti