Mission d'information sur la révision de la loi relative à la bioéthique

Réunion du jeudi 25 octobre 2018 à 14h05

Résumé de la réunion

La réunion

Mission d'information DE LA CONFÉRENCE DES PRÉSIDENTS SUR LA RÉVISION DE LA LOI RELATIVE À LA BIOÉTHIQUE

Jeudi 25 octobre 2018

Présidence de M. Xavier Breton, président de la Mission

La Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique procède à l'audition du Pr Raja Chatila, professeur à Sorbonne Université, directeur de l'Institut des Systèmes Intelligents et de robotique.

L'audition débute à quatorze heures cinq.

Mes chers collègues, nous débutons notre séquence d'auditions de cet après-midi en accueillant M. Raja Chatila, professeur à Sorbonne Université et directeur de l'Institut des systèmes intelligents et de robotique (ISIR).

Monsieur le professeur, vos travaux actuels portent notamment sur l'éthique de la robotique, les prises de décision des véhicules autonomes, l'interaction homme-robot et la connaissance de soi des robots. Nous vous remercions d'avoir accepté d'intervenir devant nous. Le sujet de l'intelligence artificielle (IA), qui soulève de nombreuses questions liées notamment aux données de santé et à la responsabilité médicale, potentielle évolution de la relation entre les médecins et leurs patients, est l'un des enjeux majeurs de la future loi de bioéthique.

C'est la raison pour laquelle nous sommes heureux de vous entendre, votre expertise nous sera utile pour faire mûrir nos propres connaissances et réflexions sur ce sujet.

Je vous laisse la parole pour un exposé liminaire, nous procèderons ensuite à un échange de questions et de réponses.

Monsieur le président, je vous remercie de m'avoir invité à venir témoigner devant cette mission d'information.

Je tenterai de vous apporter un éclairage concernant l'intelligence artificielle dans le domaine de la santé, mais aussi de façon plus générale, dans la mesure où la robotique et l'intelligence artificielle permettent de réaliser des fonctionnalités qui sont relativement proches des facultés humaines, et qui posent, de ce fait, des questions sur l'identité humaine et la dignité humaine. J'irai donc au-delà de la simple question de l'impact de l'intelligence artificielle (IA) sur la santé.

En ce qui concerne les questions de santé, je me focaliserai sur les problématiques qui peuvent être liées à la médecine « 4P » – prédictive, préventive, personnalisée et participative – dans la mesure où cette démarche de médecine prédictive s'appuie sur l'identification de pathologies qui ne sont pas encore exprimées, mais qui pourraient l'être, dès lors que le profil d'une personne saine présente des similarités avec des profils de personnes qui ont développé la pathologie, et que ces informations sont stockées dans des bases de données qui ont été traitées à travers des systèmes d'apprentissage.

Passer à la prédiction signifie que la statistique, issue des connaissances préalables, donne une certaine probabilité, pour une personne saine, de développer une pathologie dans un temps plus ou moins prévisible – ce qui transforme la personne saine en future patiente qui, à un instant donné, doit être traitée préventivement, afin que cette pathologie ne se manifeste pas, ou pour retarder sa manifestation.

De ce fait, l'impact est évidemment important, à la fois sur la santé publique puisque nous allons réduire le développement de ces pathologies, et sur la vie individuelle.

La question que nous devons nous poser concerne la qualité des prédictions, du point de vue scientifique, à partir du moment où nous les fondons sur des statistiques. Ces prédictions, fondées sur des systèmes d'apprentissage dont l'explicabilité n'est pas encore tout à fait au point, peuvent entraîner deux risques majeurs. D'une part, une identification un peu trop sommaire des pathologies possibles pour une personne donnée ; d'autre part, l'ignorance de ce que nous appelons les signaux faibles, c'est-à-dire des éléments qui se trouvent dans les données mais que le traitement statistique ne fait pas ressortir, et qui peuvent néanmoins avoir de l'importance pour un certain nombre de pathologies qui ne seraient pas identifiées.

Quelles peuvent être les conséquences ? D'abord, des conséquences éthiques, puisque la vie d'un individu peut être impactée par la prévision avancée d'une possibilité de développer une pathologie, sur la seule base de similarités statistiques, ce qui amène à traiter cette personne d'une manière particulière, aussi bien en termes d'assurance maladie – ou d'assurance personnelle – que d'hygiène de vie. Ensuite, je l'ai dit, l'ignorance des signaux faibles.

Au-delà du domaine de la santé, un autre aspect peut poser un problème éthique : le développement des robots visant la ressemblance humaine, c'est-à-dire des robots androïdes. La France ne développe pratiquement pas ce type de robot, mais ils sont particulièrement développés au Japon et aux États-Unis.

Ces robots androïdes soulèvent, de mon point de vue, un certain nombre de problèmes. D'abord, du fait de la recherche de la ressemblance humaine par l'aspect, le comportement et l'expression d'émotions, une confusion peut se créer entre une personne humaine et une machine, ce qui va nous amener à débattre de la notion même d'humanité et de dignité de l'être humain.

Cette problématique concerne le développement des robots androïdes sous toutes les formes et pour toutes applications. Je pense, entre autres, aux robots sexuels, qui peuvent prendre une forme féminine, mais aussi celle d'un enfant : se pose alors la question de l'usage qui peut en être fait.

D'autres questions se posent concernant la notion de droit du robot. Le Parlement européen, dans une résolution de février 2017, a expliqué qu'en attribuant la personnalité juridique à ces machines, elles pourraient être rendues responsables de leurs actes. Mais dans la mesure où il s'agit, non pas d'une voiture, par exemple, mais d'une entité qui ressemble à un être humain et qui tend à se comporter comme un être humain, la voie est ouverte vers la confusion entre personnalité juridique – éventuelle – et droits. Les droits sont généralement énoncés quand on cherche à protéger une entité. De mon point de vue, le fait que la personne humaine puisse être confondue avec une machine amènera assez facilement à donner à la machine des droits pour que, justement, elle puisse être préservée du fait de sa ressemblance avec la personne humaine.

Cela soulève des questions éthiques, mais aussi des questions juridiques qui peuvent passer relativement inaperçues, rien n'interdisant aujourd'hui de développer des robots androïdes ni des machines qui font semblant d'être des êtres humains. L'une d'elles s'appelle d'ailleurs Sophia, et elle est exhibée dans des conférences internationales. L'Arabie Saoudite lui a donné la citoyenneté, montrant ainsi son intérêt pour les nouvelles technologies. Il s'agit d'un exemple parmi d'autres, qui montre que nous sommes sur une pente glissante, qui peut se généraliser.

Je vous remercie.

Conviendrait-il, selon vous, d'introduire dans la loi une exigence d'explicabilité des algorithmes, selon laquelle les concepteurs de ces algorithmes mettraient à disposition des professionnels – notamment dans le domaine de la santé – des informations pour leur permettre une compréhension du fonctionnement de ces algorithmes ? Il s'agit là de recommandations de la Commission nationale de l'informatique et des libertés (CNIL) et du Conseil d'État. Cela serait-il vraiment opérationnel, et pourrait-on étendre cette exigence au patient ?

S'agissant du développement des robots androïdes, devons-nous légiférer sur ce sujet ? De quelle manière ? Ou devons-nous, justement, ne pas légiférer pour ne pas aller vers une personnalité juridique des robots ?

Enfin, selon vous, devons-nous nous situer dans une logique de législations nationales, ou bien dans une logique européenne, voire mondiale ?

L'exigence d'explicabilité est importante, car elle ne va pas de soi. Un cadre devra être élaboré et il faudra poser un impératif de transparence, d'abord de la part de l'entité qui exploite le système – je ne parle pas de son concepteur. Elle devra expliquer comment son système fonctionne, sans remettre en question, bien entendu, la protection de la propriété industrielle ou intellectuelle. Si le système fonctionne sur des bases de données d'apprentissage, elles devront être accessibles, afin que l'on puisse vérifier qu'il n'a pas été affecté de biais. Si un certain nombre de valeurs, de priorités, ont été choisies pour être prises en compte dans les décisions du système, elles devront, elles aussi, être connues.

Mais à qui devra-t-on expliquer ces algorithmes ? Aux spécialistes ? Aux patients ? À une autorité de certification ou de contrôle ? Dans tous les cas, l'exigence d'explicabilité nécessitera la transparence et les systèmes déployés devront pouvoir être certifiés. Les agences de certification devront donc se saisir des informations, tout comme les professionnels amenés à comprendre pourquoi la décision a été prise. Dans le domaine médical, c'est le médecin qui devra être le destinataire de l'explicabilité, à charge pour lui de transmettre, ensuite, les informations au patient.

S'agissant des robots androïdes, il sera difficile de légiférer sur leur développement : le cadre serait trop difficile à définir. En revanche, ne pas légiférer sur la notion de personnalité juridique me semble très important, et ce pour deux raisons : d'une part, la confusion possible entre l'être humain et la machine, quelle que soit la forme de celle-ci ; d'autre part, le risque de dédouaner le concepteur de ses responsabilités. Dans la mesure où ce dernier déploie un système, il doit, comme pour tout système technologique, être tenu pour responsable de ses conséquences et de ses dysfonctionnements. Et il le sera plus facilement si des standards industriels sont déterminés, visant à garantir le respect de ces exigences. Je suis donc d'avis de ne pas légiférer sur la notion de personnalité juridique.

Par ailleurs, si ces questions se posent sur un plan international, négocier des traités sera extrêmement compliqué. Le niveau européen est beaucoup plus aisé à envisager.

Merci de vos éclaircissements. Avant de laisser la parole au rapporteur, je rappellerai que la Nouvelle-Zélande a donné la personnalité juridique à un fleuve !

Je prolongerai cette question de la personnalité juridique, qui est importante. Ce matin, il nous a été donné tous les arguments pour lesquels il conviendrait de ne pas donner la personnalité juridique aux robots. Mais que devrons-nous faire si d'autres pays légifèrent en ce sens ?

Les malades reçoivent de plus en plus de propositions commerciales d'objets connectés, apparemment nourris d'informations confidentielles qui ont été détournées ou qui ont « fuité » : les diabétiques, par exemple, reçoivent des propositions concernant de nouveaux dispositifs connectés pour le diabète, les hypertendus pour l'hypertension, etc.

Deux problèmes se posent : d'une part, celui de la confidentialité, qui aurait dû empêcher que des commerciaux aient accès à ces dispositifs ; d'autre part, celui de la sanction à infliger à ceux qui s'approprient ces données.

Par ailleurs, qu'allons-nous faire si ce genre de procédure se multiplie ? Pour l'instant, il s'agit d'objets qui ne sont pas vraiment indispensables, parfois même pas utiles, mais peu à peu les patients deviennent vulnérables à ces propositions multiples et nous risquons une inflation de propositions commerciales qui ne fera que s'accentuer si nous n'y mettons pas bon ordre. Comment se protéger contre ce type de propositions ?

Le Comité consultatif national d'éthique (CCNE) propose la création d'un comité d'éthique spécifique pour le numérique. Qu'en pensez-vous ?

Enfin, ce matin, l'un de nos interlocuteurs nous a expliqué les avantages qu'il y aurait à créer un observatoire, dont la mission serait d'identifier tout ce qui se fait au niveau mondial afin de se prémunir d'objets, de systèmes, de dispositifs, provenant d'Asie ou autres, ne correspondant pas aux valeurs que nous souhaitons faire respecter dans notre pays. Êtes-vous favorable à un tel observatoire ? Si oui, doit-il être national ? Européen ?

Ces questions sont effectivement fondamentales.

S'agissant de la personnalité juridique et de la façon de se prémunir d'une initiative inopportune, je pense que l'Europe est suffisamment puissante et écoutée pour ne pas craindre ce qui vient d'ailleurs. Par ailleurs, elle donne l'exemple, en particulier à travers des réglementations protectrices du citoyen européen, comme le règlement général sur la protection des données (RGPD). En ce sens, il convient de continuer de considérer qu'une machine est une machine, donc un objet, et de ne pas tomber dans le piège qui consiste à dire que, puisqu'il y a un ordinateur derrière, cette machine a des capacités de prise de décisions...

Et dans la mesure où une machine est une machine, son exportation doit respecter un certain nombre de normes et de critères, qui la ramènent à sa qualité de machine. Il faudra donc ne pas reconnaître des appellations, des nominations, des caractérisations qui seraient données dans d'autres pays à des machines pour les assimiler à des humains. Rien ni personne ne peut obliger l'Europe à le faire.

Par ailleurs, si l'industrie européenne se trouvait impactée par un tel dispositif, elle serait, de fait, protégée et les pays européens ne pourraient pas tomber dans les mêmes travers, c'est-à-dire développer des systèmes de ce type.

Concernant la manière dont des malades sont approchés, sur la base d'informations confidentielles, par des commerciaux vendant des objets connectés, la confidentialité des données est un sujet extrêmement important et difficile à traiter. Il n'y a pas de code qu'on ne puisse « craquer ». Protéger les données collectées ou stockées par ces objets connectés est d'une grande importance. Je n'ai pas de proposition concrète à formuler, mais il convient de protéger le citoyen européen contre ces éventualités, de même que contre les produits pouvant être développés ou présents sur le marché dans d'autres domaines, et qui impactent ou dérangent la vie dudit citoyen. Car, au fond, il s'agit de cela : protéger les personnes vulnérables susceptibles d'être démarchées. La vulnérabilité peut être un critère de protection.

Il est certes possible de traiter la question de la protection des données personnelles acquises par objets connectés en programmant ces objets : par exemple, réaliser des machines dont l'utilisateur pourrait déterminer ce qui doit être oublié, ce qui doit être protégé, etc. Mais il s'agirait là d'une démarche relativement limitée, puisqu'une machine n'oublie rien, tout étant mis dans une case-mémoire qui n'est plus accessible à l'utilisateur, mais qui peut l'être à un spécialiste, notamment à un spécialiste malveillant.

Enfin, je suis plutôt favorable à la création d'un comité d'éthique du numérique et d'un observatoire, étant donné ce qui se passe au plan international.

Un observatoire nous permettrait d'obtenir une source d'informations fiables et évaluables quant aux développements qui sont cours à l'étranger. Un observatoire européen me paraît plus pertinent, même s'il n'est pas toujours facile de réaliser une structure européenne. Les valeurs et les critères peuvent être différents selon les pays, alors même que ces sujets sont discutés au sein du groupe de haut niveau sur l'IA, dont je fais partie. Cinquante-deux experts conseillent l'Union européenne dans sa politique, à la fois éthique et d'investissement.

Un comité français d'éthique du numérique serait également utile, car il s'agit d'un domaine vierge de toute évaluation éthique : en d'autres termes, tout est permis. En effet, dès lors qu'il n'y a pas d'expérimentation humaine, il n'y a pas de comité de protection des personnes (CPP) ni de CCNE à consulter. Tout devient possible et des prototypes, des systèmes peuvent être développés, qui aient un impact sur les êtres humains. C'est pourquoi un comité d'éthique du numérique serait pertinent.

L'audition s'achève à quatorze heures trente-cinq.

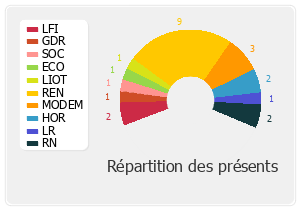

Membres présents ou excusés

Mission d'information de la conférence des présidents sur la révision de la loi relative à la bioéthique

Réunion du jeudi 25 octobre 2018 à 14h05

Présents. – M. Xavier Breton, Mme Élise Fajgeles, Mme Agnès Thill, M. Jean-Louis Touraine, Mme Annie Vidal

Excusée. – Mme Bérengère Poletti